【AI简报】. 谷歌正式发布自研芯片、 平头哥发布自研 CPU

嵌入式 AI

1. 谷歌正式发布Tensor自研芯片:探索智能手机AI应用新战场

原文链接:

http://www.elecfans.com/d/1719175.html

昨天苹果和阿里推出的自研芯片赚足了各路眼球,在像“地表最强”、“倚天一出谁与争锋”之类的头衔下,今天(10月20日)凌晨发布的谷歌首款自研芯片Tensor显得略显暗淡,但其在Pixel 6系列手机上所实现的AI功能依然有不少亮点。

作为被搭载在新款Pixel 6系列手机上的芯片,Tensor的性能从跑分成绩上看,与当下安卓手机普遍采用的骁龙888成绩相差不远。

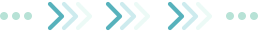

Tensor采用了较为激进的2+2+4的核心架构,包括两个Arm Cortex-X1大核,两个Cortex-A76以及四个A55小核,并搭配20核Mali-G78 GPU,由三星5nm工艺制造。相比于上一代Pixel5上搭载的骁龙765G,谷歌表示Tensor的CPU性能提升了80%,GPU提升了370%之多。

Pixel系列手机一直以来是计算摄影的业界标杆之一,因此Tensor的核心亮点毫无疑问是在AI运算上,谷歌引入了TPU为Pixel 6系列手机的AI应用提供算力。

借助TPU的能力,Pixel 6可以将翻译模型下载到本地,再通过Tensor的机器学习算法,实现完全离线的状态下依然可以得到快速准确的翻译结果。这一功能也被谷歌整合进Gboard输入法中,可以做到在输入法中打出中文,直接得到在聊天框中得到英文的效果。

在影像方面,Pixel 6系列在硬件上的升级也相当大,Pixel 6与Pixel 6 Pro主摄像头均搭载了 5000万像素GN1传感器。其中Pixel 6 Pro还增加了支持4倍光学变焦的4800万像素长焦镜头,搭配谷歌超分辨率技术,最高实现20倍数码变焦。

当然,在摄影上,凭借Tensor新增的AI算力,谷歌也加入了一些更加智能的玩法。比如在发布会中被重点介绍的Magic Eraser(魔法橡皮)功能,可以让用户在拍摄完成后,借助算法删除照片背景中的人或物。

Pixel系列的HDR算法一直以来都有着出色表现,这次加入新的HDR算法同时,Pixel 6还支持HDR视频拍摄。虽然早已有其他安卓手机支持HDR10视频拍摄,但Pixel 6的效果依然值得期待。

另外,谷歌对于照片模糊上也似乎有很深的理解。比如在这次Pixel 6上推出的Face Unblur,可以对拍摄人物运动时造成的人脸模糊进行修正。不过相比于效果,谷歌的解决方法就比较简单了。

在每次按下快门时,主摄和超广角会同时进行拍摄,捕抓两张照片,其中超广角曝光时间更短,即出现模糊的概率更低。后期处理中将两张照片进行计算融合,就可以得到清晰的画面效果。

但在摄影中,未必是越清晰越好,在特定场景下,比如拍摄水流、车流等运动物体时,也需要一定的模糊效果。所以谷歌带来了Motion Mode,在开启后,手机会捕捉一组照片,通过机器学习识别画面主题,确定运动矢量,确保主体清晰的情况下插值中间帧以产生动态模糊。

除此之外,谷歌还增强了自动白平衡、自动曝光等算法,接住机器学习减少肖像杂光,以还原真实色彩。

虽然在芯片硬件上亮点不多,但这只是谷歌第一款自研移动芯片,在发布会上也能感受到,Tensor的推出重点并不在于纸面数据有多强,而是在于机器学习算法能为智能手机带来怎样的体验提升。与此同时,新一轮自研芯片的潮流,或许还会给智能手机行业带来一股新鲜血液。

2. 阿里巴巴平头哥发布自研 CPU 芯片倚天 710:采用 5nm 工艺,“业界性能最强 ARM 服务器芯片”

原文链接:

https://www.ithome.com/0/581/322.htm

在今日举行的 2021 云栖大会现场,阿里巴巴旗下半导体公司平头哥发布自研云芯片倚天 710。据官方介绍,该芯片是业界性能最强的 ARM 服务器芯片,性能超过业界标杆 20%,能效比提升 50% 以上。该芯片已在 7 月份流片,将在阿里云数据中心部署应用。

和 2019 年发布的 AI 推理芯片含光 800 不同,倚天 710 是一颗通用服务器 CPU 芯片。倚天 710 采用业界最先进的 5nm 工艺,单芯片容纳高达 600 亿晶体管;在芯片架构上,基于最新的 ARMv9 架构,内含 128 核 CPU,主频最高达到 3.2GHz,能同时兼顾性能和功耗。在内存和接口方面,集成业界最领先的 DDR5、PCIE5.0 等技术,能有效提升芯片的传输速率,并且可适配云的不同应用场景。

官方称,为解决云计算高并发条件下的带宽瓶颈,倚天 710 针对片上互联进行了特殊优化设计,通过全新的流控算法,有效缓解系统拥塞,从而提升了系统效率和扩展性。在标准测试集 SPECint2017 上,倚天 710 的分数达到 440,超出超过业界标杆 20%,能效比提升 50% 以上。

对于平头哥而言,倚天 710 芯片是首个通用服务器芯片,倚天芯片的研制成功,标志着平头哥已经具备大型复杂芯片的研发设计能力,并进入一流芯片公司的行列。

3. 发挥可重构计算优势 清微智能为可穿戴设备带来更好的使用体验

原文链接:

https://mp.weixin.qq.com/s/b8egX4UWLFrSGm1pDx4gAw

智能语音已经不是一种新的技术,它正逐渐发展成为电子产品的标配,随着技术的发展,使用者一定会对其依赖的程度逐渐加深,智能语音会从目前的补充辅助作用变为真正的一种需求。

清微智能是可重构计算芯片领导企业,提供以端侧为基础,并向云侧延伸的芯片产品及解决方案。该公司最新量产的TWS主控芯片TX231采用异构架构进行设计,是全球第一款集成独立混合粒度可重构计算核的蓝牙SOC芯片,支持神经网络处理以及传统音频信号处理。

TX231

清微智能对电子发烧友表示,这颗独立的可重构核,采用清微核心的可重构计算技术,没有传统指令驱动的计算架构中取指和译码操作的延时和能耗开销,同时针对神经网络逻辑和非神经网络逻辑均进行了计算效率考虑。针对非神经网络处理逻辑,从算法数据流图进行空间映射,以接近ASIC效率计算;而对于非神经网络,可重构架构通过配置形成不同的电路结构来动态处理不同,在保证灵活性前提下,计算效率有极大提升。

可重构计算核通过混合粒度的异构设计,在能效比上表现优异,能高效支持语音交互控制,通话降噪,环境检测,ENC(环境降噪),ANC(主动降噪),TX231DAC信噪比达121dB,支持业界领先的768K超高采样率,在蓝牙音乐播放时的功耗仅有 4.8mA,通话功耗为5.5mA,加入深度降噪算法后功耗增大也不足0.25mA,为TWS耳机在音质的提升,续航体验上打开了一种全新的局面。

另外在算法上也给了厂商灵活的选择空间,合作的终端厂商可使用清微自带的免费算法,或者使用第三方算法,也可在平台上进行自己的算法开发。高度简化的开发过程和强大的兼容性,可以让厂商投入更多精力打造差异化产品,为市场带来性能更好,更适应消费者各方面需求的高性价比产品。

语音芯片的竞争核心是性能和功耗,能不能在更低的功耗下,拥有更强的算法处理能力是关键,有些公司通过更高的工艺来实现,清微智能则依靠芯片结构的创新,这是公司最核心的优势。

清微智能的可重构计算芯片架构技术通过空域硬件结构组织不同粒度和不同功能的计算资源,通过运行过程中的硬件配置,调整硬件功能,根据数据流的特点,让功能配置好的硬件资源互连形成相对固定的计算通路,从而可以以接近“专用电路”的方式进行数据驱动下的计算。当算法和应用变换时,再次通过配置,使硬件重构为不同的计算通路去执行。实现了“应用定义软件、软件定义芯片”,其高能效、低功耗、超强灵活性和弹性可扩展性的特点,在语音应用场景中,可以很好的发挥出优势来。

清微智能的语音芯片主要应用在可穿戴设备,清微智能谈到,从原始社会钻木取火,到农业时代的犁、锄、水车,到工业时代的蒸汽机、汽车、飞机,再到信息时代的计算机、网路、生物科学、太空技术,我们可以看到:“人”作为技术的发明者和使用者,是所有技术战略的核心,一切的技术进步是以满足人类的需求为出发点,即让人类享有更便捷、更舒适、更健康的生活体验。

4. 苹果M1 Max芯片发布:570亿晶体管,图形性能堪比RTX 3080

原文链接:

https://mp.weixin.qq.com/s/MY_bGK_EHPEWkLfrScGSRw

有人说,M1 芯片的笔记本还只是个玩具,昨天的发布会上,苹果把 M1 芯片的面积再扩大 3.5 倍,堆出 570 亿个晶体管,现在生产力够不够?

这个数字,已经比英伟达 GeForce RTX3090 上的 GA102 核心(280 亿)还要夸张很多了。

虽然比性能不能只看晶体管数量,但苹果用 5nm 工艺还能做到功耗更低。

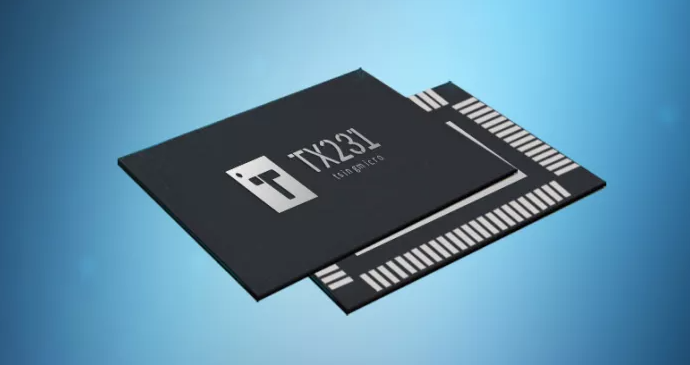

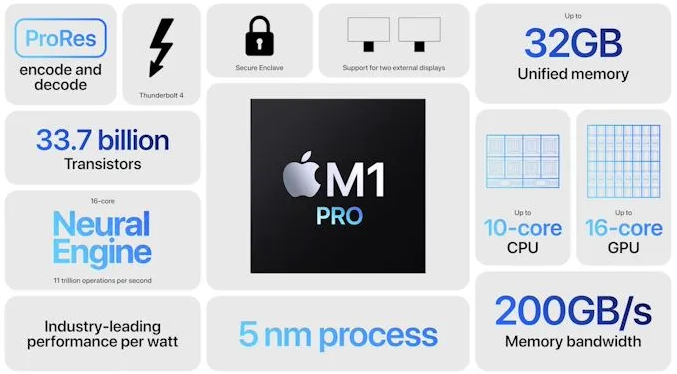

当地时间 10 月 18 日,苹果宣布推出两款突破性芯片 M1 Pro 和 M1 Max。M1 Pro 扩展了 M1 架构,提供了惊人的性能和行业领先的能效,而 M1 Max 将这种提升再上了一个新的高度。M1 Pro 和 M1 Max 也是首次将片上系统 (SoC) 架构引入 pro 系统,在内存带宽、功效、容量等方面都有新的突破。

相比于 M1,M1 Pro CPU 的性能提升了 70%,GPU 提升 3 倍。相对于传统的 8 核 x86 处理器、传统集显和大功率独显,同功耗下 M1 Pro 性能更高,同等性能的情况下 M1 Pro 的功耗更少(少 70% 功耗)。

M1 Pro 芯片采用 5nm 制程工艺,封装晶体管数达到 337 亿个;10 个 CPU 内核,包括 8 个高性能核和 2 个高能效核;16 核 GPU;最高可配置 32GB 统一内存,内存带宽达到 200GB/s。

而 M1 Max 除了与 M1 Pro 拥有同样的 10 核 CPU 以外,其余规格都又提升了一大步。M1 Max 封装晶体管数达到 570 亿,芯片面积达到 432mm²,比 M1 Pro 都多出 70%,是 M1 的 3.5 倍。M1 Max 芯片也是苹果迄今打造的最大面积芯片。

AI新闻

5. 登上Science子刊,神经科学再次启发DNN设计!中科院揭秘介观自组织反向传播机制

原文链接:

https://mp.weixin.qq.com/s/x9dCTEwDk0Uiho2eCubYRA

在人工智能领域,目前人工神经网络中被广泛使用的反向传播算法(Backpropagation,BP)采用全局优化策略,这种端到端的学习方法性能卓越,但学习过程能量消耗大,且缺乏灵活性。中科院脑智卓越中心徐波、蒲慕明联合研究团队近期借助生物网络中发现的介观尺度自组织反向传播机制(Self-backpropagation,SBP),在更具效率和灵活性的类脑局部学习方法方面取得了重要进展。

SBP的发现最早可以追溯到1997年。蒲慕明团队在Nature杂志上撰文发现海马体内的神经元可以将长时程抑制(Long-term depression,LTD)可塑性自组织地传播到三个方向,分别是突触前侧向传播(Presynaptic lateral spread)、突触后侧向传播(Postsynaptic lateral spread)、反向传播(Backpropagation)[1],这个发现就是自组织反向传播神经可塑性机制(SBP)。后续研究证实,SBP现象具有普遍性,不仅覆盖更多的神经区域如视网膜-顶盖系统[2],还覆盖更多的可塑性类型[3],如长时程增强(Long-term potentiation,LTP)。该机制的发生归结于生物神经元内分子调制信号的天然逆向传递,被认为是可能导致生物神经网络高效反馈学习的关键[4]。

研究团队受到该机制的启发,对SBP的反向传播方向(第三个方向)单独构建数学模型(图1A),重点描述了神经元输出突触的可塑性可以反向传播到输入突触中(图1B),可塑性的发生可以通过时序依赖突触可塑性(Spike timing-dependent plasticity,STDP),也可以通过人工局部梯度调节。在标准三层脉冲神经网络(Spiking neural network,SNN)的学习过程中,SBP机制可以自组织地完成前一层网络权重的学习,且可以结合短时突触可塑性(Short-term plasticity,STP)、膜电位平衡(Homeo-static membrane potential)等,形成更强大的SNN组合学习方法(图1C)。

在一类人工神经网络(Artificial neural network,ANN)如受限玻尔兹曼机网络(Restricted Boltzmann machine,RBM)的学习中(图2A),SBP机制也可以替换迭代过程中部分BP机制,实现交替的协作优化(图2B-E)。针对SNN和RBM的不同,团队又分别设置了两种不同的能量函数约束,来保证训练过程中网络参数学习的平稳性。此外,研究团队针对性地提出了一种统计训练过程中能量消耗的新方法(图3)。在图片分类(MNIST)、语音识别(NETtalk)、动态手势识别(DvsGesture)等多类标准数据集上,SBP机制通过组合其它可塑性机制,实现了更低能耗和更高精度的SNN局部学习(图4)。在ANN-RBM的学习中,SBP机制也可以大量的替换BP机制实现全局和局部交叉学习,在降低计算能耗同时却不损失精度(图5)。

研究人员认为,SBP是一类介观尺度的特殊生物可塑性机制,该机制同时在SNN和ANN中获得了广泛的组合优化优势,对进一步深入探索类脑局部计算具有很大的启示性。生物智能计算的本质,很可能就是灵活融合多类微观、介观等可塑性机制的自组织局部学习,结合遗传演化赋予的远程投射网络结构,实现高效的全局优化学习效果。该工作可以进一步引导生物和人工网络的深度融合,最终实现能效比高、可解释性强、灵活度高的新一代人工智能模型。

相关工作(Self-backpropagation of synaptic modifications elevates the efficiency of spiking and artificial neural networks)于2021年10月20日(美东时间)在线发表于《科学》子刊《Science Advances》上。中国科学院自动化研究所类脑智能研究中心张铁林副研究员为第一作者,徐波研究员为通讯作者,程翔(博士生)、贾顺程(博士生)、蒲慕明研究员和曾毅研究员为共同作者。相关研究工作得到了国家自然科学基金委、先导B等项目的资助。

相关论文地址见:https://www.science.org/doi/10.1126/sciadv.abh0146

图1:SBP在SNN中的应用

6. 揭榜任务发布,工信部为AI创新定下高规格

原文链接:

https://mp.weixin.qq.com/s/CsFUZtre_lLvemek8ZctzA

10月14日,工信部印发了一份与人工智能相关的通知,宣布开展2021年人工智能产业创新任务揭榜挂帅申报工作,进一步探索完善揭榜挂帅机制,促进企业创新。对于人工智能这种科研密切相关的技术,“揭榜挂帅”的模式有效杜绝了“论文导向”的科研怪圈,转为以需求和成果为导向。申报并入围后,相关单位将开展技术攻关,工信部将在两年内跟踪测评,最终选出优胜单位。

本次揭榜挂帅工作分为三类创新任务,芯片、传感器、框架与开发服务平台等核心基础任务,机器翻译、身份识别、语音交互、自动驾驶仿真、智能机器人/无人机等智能产品任务,以及训练资源库、预训练模型、安全监测平台等公共支撑任务。

实际上,早在去年,工信部就公布了新一代人工智能产业创新重点任务揭榜优胜单位名单,业界不少头部AI产品与方案均获此殊荣。该名单的筛选工作从2018年底就已经启动,经过持续的评定才决出优胜单位。而此次发布的2021年申报指南中,工信部为2023年的国产AI发展定下了不少参数目标,我们不妨用这些目标与现有产品的参数做个对比参考。

云端人工智能芯片——高算力低功耗

在云端人工智能环境中,训练芯片与推断芯片都是不可或缺的。申报指南给出的预期目标里,工信部指出到2023年,人工智能的云计算环境需要支持三种以上主流神经网络的训练与推断,比如计算机视觉、自然语言处理与智能语音等。与此同时,训练与推理芯片可支持FP32、TF32、FP16与INT8等常用计算精度。训练芯片要求算力达到32TFLOPS@FP32、64TFOPS@TF32、512TOPS@INT8,但芯片的典型功耗不得高于400W。

思元290芯片 / 寒武纪

直接给出这些参数可能难以理解其概念,我们先拿现有的几个旗舰训练芯片对比一下,比如位列揭榜优胜单位的寒武纪。寒武纪的思元290基于台积电7nm工艺,算力达到512TOPS@INT8,且功耗只有300W。华为的昇腾910芯片同样采用了台积电7nm工艺,算力达到640TOPS@INT8,功耗为310W。

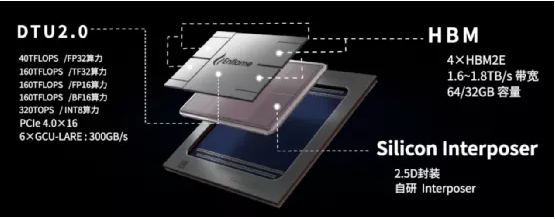

邃思2.0芯片 / 燧原科技

然而在AI训练中,往往需要用到FP32以上的高精度或混合精度,因此目标中32TFLOPS@FP32与64TFLOPS@TF32等参数反而更加关键。燧原科技的邃思2.0芯片目前看来在单精度浮点计算上性能最高,该芯片采用格芯的12nm工艺打造,其算力指标最高达40TFLOPS@FP32,且支持TF32精度并实现160TFLOPS算力,最大功耗也只有300W。

那么这个基准线与国外大厂相比又如何呢,我们可以对比英伟达最新的A100芯片,该芯片也用到了台积电的7nm工艺,算力表现分别是624TOPS@INT8、19.5 TFLOPS@FP32,最高功耗为400W。特斯拉在近期公布的D1芯片,也只做到了22.6 TFLOPS@FP32和400W的性能。如此看来,这确实是一个高规格的预期目标,不过决定云端人工智能芯片表现的不仅是算力与功耗,还要看其扩展能力与带宽等。

小结

在这份申报指南中,工信部已经为人工智能的创新给出了相当详细的攻坚方向,足见国家对AI产业的重视。除了相关企业外,高校和科研院所同样是创新的中坚力量,尤其是在公共支撑类产品的建设上。在产学研的共同努力下,揭榜挂帅这种模式才能发挥出国内AI最大的优势。

7. 英特尔:80%的边缘数据都是视频数据!新成立物联网视频事业部,总部base中国

原文链接:

https://mp.weixin.qq.com/s/yGbBBSRGfvWaAlVG-n1CZw

没想到,为了让你逛商店更爽,英特尔竟然也出手了。

现在,通过普通的摄像头+一套门店客流系统,商家就能知道一天的客流量、顾客平均停留时间、行动轨迹、试吃次数等等人力难以统计的数据。

而且还不会泄露顾客的隐私。

因为这套系统不会识别顾客的面部信息,只是通过骨骼点识别动作,并会对识别到的信息匿名化处理,只用临时的编号代表进店顾客。

依靠这些数据,商家就能对货架摆放、商品区域重新调整,从而投其所好,让你的购物体验更爽。大厂出手果然不凡。难道……英特尔要做新零售了???

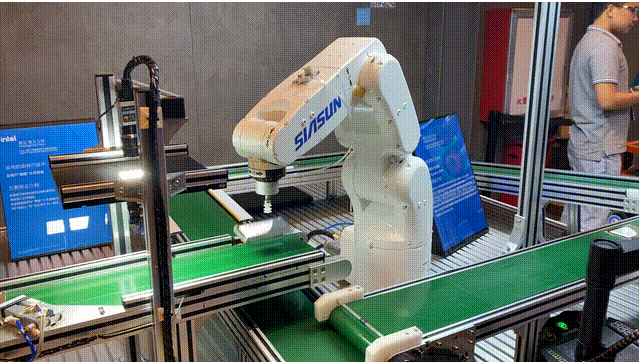

当然不是。以上这个案例,只是英特尔在AIoT业务中的一隅。其实在工业、交通、教育、在线办公等领域,都能发现英特尔的身影。比如机器人判断货物是否有瑕疵、分拣优劣品;停车场无人化智能管理停车;系统核查工人是否佩戴安全头盔等等……

那么英特尔到底做了什么呢?

有硬件支持,也有软件结合。

以上面门店客流系统案例来说:

硬件上,它采用了英特尔®AI超级计算盒,它负责在本地完成对拍摄视频的处理、AI推理和数据量化等流程,解决边缘端遇到的复杂计算问题。

软件方面则用了OpenVINO™工具套件,它提供了对神经网络的开发和部署,包括模型优化器和推理引擎,支持高度优化的神经网络计算能力,并能够支持英特尔CPU、集成GPU、VPU以及FPGA在内的英特尔硬件平台,加速模型的推理工作。

这样的组合使得很多计算不用上传至云端、在边缘端就能进行。

由此可以在保证数据安全的同时,还能降低延迟。

据IDC报道,预计到2023年,43%的AI计算将会发生在边缘端(同比云端)。

事实上,就在不久前,英特尔在AIoT上还有了新布局。

那就是聚焦视频数据。

仔细观察就会发现,如上列举的案例中,无论是门店识别顾客、还是机器识别产品的瑕疵,其实都离不开视频图像数据的收集。

英特尔公司物联网事业部副总裁、物联网视频事业部全球总经理陈伟博士就指出:80%的边缘数据是视频数据。

在第十四届英特尔物联网峰会上他表示,最近几年人工智能才找到真正具体落地场景的一大原因,就是视频数据的爆发。预计到2025年,我国将会有10亿个高清网络摄像头。怎么样?快来加入马上起飞的CV大军吧!

8. 登顶CLUE榜单,腾讯云小微与腾讯AI Lab联合团队提出基于知识的中文预训练模型

原文链接:

https://mp.weixin.qq.com/s/CavGiy1Rz0MJVtcxXdSn0A

2018年以来,以BERT、GPT等为代表的大规模预训练模型,带来了人工智能领域新的突破,由于其强大的通用性和卓越的迁移能力,掀起了预训练模型往大规模参数化发展的浪潮。其中微软、谷歌、Facebook、NVIDIA等诸多公司在预训练算法上持续大量投入。国内如百度、华为、阿里等公司也相继投入到大规模预训练模型算法的研究中。现阶段,在中文自然语言处理方向上,预训练也如雨后春笋一样涌现。现有算法主要依赖纯文本学习,缺少知识指导学习,模型能力存在局限。

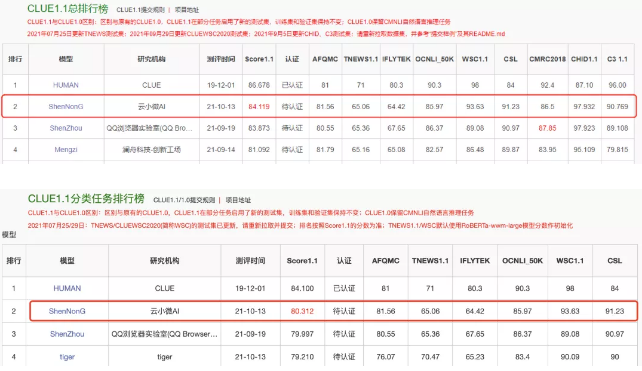

2021年10月13日,腾讯云小微与腾讯AI Lab联合团队提出了基于知识的中文预训练模型——“神农”,该模型仅包含十亿级参数量,并一举登顶CLUE总排行榜、1.1分类任务、阅读理解任务和命名实体任务四个榜单,刷新业界记录。

10月13日,“神农”刷新CLUE分类榜单纪录;HUMAN 为人类标注成绩,非模型效果,不参与排名。

作为中文语言理解领域最具权威性的测评基准之一,CLUE涵盖文本相似度、分类、自然语言推理、阅读理解、NER等众多语义分析和理解类子任务。近段时间,各大公司纷纷用CLUE作为预训练算法能力的验证和衡量标准。此次登顶CLUE榜单,不仅代表了云小微与腾讯AI Lab联合团队在中文预训练研究领域达到业内领先水平,并且推动中文预训练模型在理解和推理方面提升了一个新高度。

9. 虚拟在左,真实在右:德国学者用AI合成一亿像素逼真3D图像,可任意旋转

原文链接:

https://mp.weixin.qq.com/s/yB7kmcckT9H4jWuqMnuPWQ

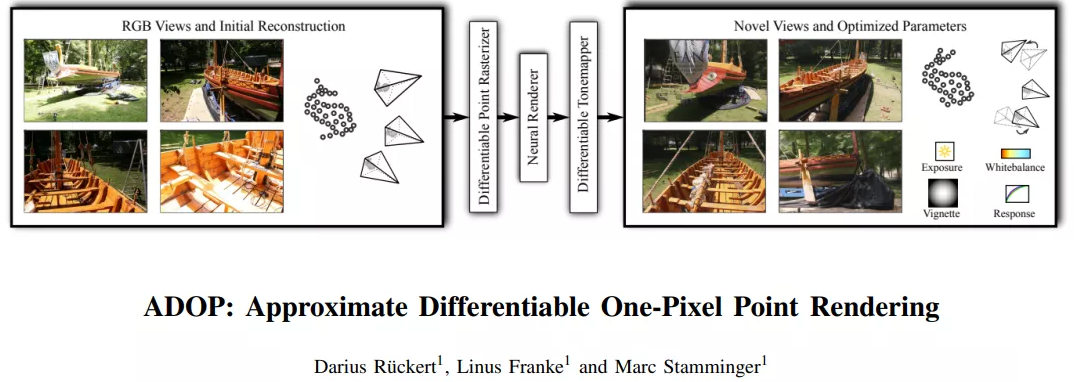

近日,来自德国埃尔兰根-纽伦堡大学的学者提出了一种新颖的神经网络方法,用于3D图像的场景细化和新视图合成。

只需要输入点云和相机参数的初始估计,就可以输出由任意相机角度合成的图像,360度旋转都不是问题。

研究人员表示,高效的单像素点光栅化让他们能够实时显示超过 1 亿个像素点的点云场景。

一亿个像素点是什么概念?说白了,这些3D图像太逼真了。

再看看合成图和原图的对比,简直和拍照没啥区别。

这项研究最近在推特上收到了很大的关注,网友纷纷回应:impressive!同时,也有网友表示,这项研究确实利用了大规模动态输入点云的优势,而这原本是“超级难”的问题。

如下图所示,给定一组RGB图像和初始3D重建(图左),该渲染方法能够合成新的帧,并优化场景参数(图右)。

论文地址:https://arxiv.org/pdf/2110.06635v1.pdf

用神经网络自动学习合成高清3D图像已有成效,但之前还难以做到大动态的视角变换,他们是怎么实现的呢?感兴趣的读者可以下载原文研究研究。

聊点技术

10. 图灵奖得主Yann LeCun万字访谈:DNN“史前文明”、炼金术及新的寒冬(有点长,但是强烈建议阅读!!)

原文链接:

https://mp.weixin.qq.com/s/J0diLgy27-zHlZYwYy5E4w

Yann LeCun,现任 Facebook 副总裁兼首席 AI 科学家,纽约大学教授,曾在 Facebook 内领导开启了 AI 研究,并领导建设了纽约大学的数据科学中心。Yann 以其在上世纪八九十年代率先将卷积神经网络(CNNs)用于图片处理而闻名,被认为是对深度学习理论发展构成重大影响的人物之一,也由此获得了计算机领域最高奖项图灵奖。